ВУЗ: Не указан

Категория: Не указан

Дисциплина: Не указана

Добавлен: 05.12.2019

Просмотров: 12597

Скачиваний: 26

31

Сравнивая объемы информации русского текста и английского, мы видим,

что на английском языке информации меньше, чем на русском. Но ведь

содержание не изменилось! Следовательно, при алфавитном подходе к

измерению информации ее количество не зависит от содержания, а зависит

от мощности алфавита и количества символов в тексте. С точки зрения

алфавитного подхода, в толстой книге информации больше, чем в тонкой.

При этом содержание книги не учитывается.

Правило для измерения информации с точки зрения алфавитного подхода:

1) Найти мощность алфавита - N

2) Найти информационный вес одного символа i из уравнения 2

i

= N

3) Найти количество символов в тексте - К

4) Найти количество информации - I (информационный объем всего

сообщения)

Для измерения больших объемов информации используют следующие

единицы:

1Кб = 2

10

байг= 1024 байга

1Мб =2

10

Кбакг = 1024 Кб

1Гб = 2

10

Мбайг = 1024 Мб

4. Информационные уровни документов.

Каким образом можно подсчитать количество информации в документе?

Прежде чем попытаться ответить на этот вопрос, нужно сделать два

предварительных замечания. Во-первых, следует признать, что в настоящее

время отсутствует универсальная мера для измерения количества

информации. Есть лишь условные меры, которые характеризуют

информацию, содержащуюся в определённом документе, предназначенном

для соответствующего потребителя, в конкретной ситуации. И, во-вторых,

любой документ является многоуровневой информационной системой, где

каждый уровень имеет свои количественные параметры. Есть физический

уровень,

синтаксический

(знаковый),

семантический

(значимый),

структурный, латентный и др.

Для определения количества информации необходимо прежде всего

воспользоваться

общенаучным

методом

измерения.

Поскольку

документированная информация всегда содержится на каком-либо

материальном носителе, постольку первое, самое общее представление о её

количестве может дать физический уровень, т.е. натуральный (физический)

объём, занимаемый информацией. Так, первоначальное представление о

документах на бумажных носителях можно получить, измерив их в

32

килограммах, в кубических метрах, а также по количеству единиц хранения

(дел) и даже по длине полок в архивохранилищах. Для аудиовизуальных и

машиночитаемых документов могут быть использованы такие единицы

измерения как длина киноплёнки или магнитной ленты в метрах, количество

фотографических кадров, видеокассет, магнитных или оптических дисков и

т.п.

Информационный объём письменных документов можно выразить в

печатных листах, условных печатных листах, в учётно-издательских и

авторских листах, перейдя таким образом на синтаксический (знаковый)

уровень. Печатный лист - это оттиск на одной стороне листа бумаги формата

60 * 90 см. В условных печатных листах просчитываются оттиски на бумаге

других форматов (например, 70 * 90 см и др.) через специальный

коэффициент. Учётно-издательский лист, также как и авторский лист, равен

40 тыс. печатных знаков, включая пробелы между словами, или 3000 см\

графического материала (иллюстраций, карт и т.п.).

В информатике количество информации определяется с помощью такой

единицы измерения как бит (двоичная цифра, используемая для кодирования

любой информации). Восемь бит составляют 1 байт; 1 килобайт (Кбайт) -

1024 байт; 1 мегабайт (Мбайт) = 1024 Кбайт = 1048576 байт; 1 гигабайт

(Гбайт) = около 1 млрд байт.

Однако физический объём документа, также как и количество знаков в нём,

т.е. синтаксический уровень, не дают представления о реальном количестве

информации в документе. Подсчитать же это реальное количество весьма

непросто. Не случайно отдельные авторы вообще считают подобный подсчёт

невозможным. В поисках наиболее эффективных путей измерения реального

количества документированной информации предлагаются различные

способы, используются различные понятия. В частности, некоторые

исследователи (Б.В.Бирюков, Г.Г.Воробьёв) предлагают так называемый

тезаурусный подход. Для обозначения реального количества информации,

вложенного в какой-либо информационный объём (в книгу, газету,

официальный документ и т.п.), вводится понятие информационная ёмкость.

Реальное

же

количество

информации,

извлекаемое

конкретным

потребителем, обозначается понятием информативность документа.

Содержание всей информации в определённой информационной системе

называется ''тезаурус " (от греч. "thesauros" - запас). "С точки зрения

информативности тезаурус каждого сообщения делится на три части:

1) основная информативность - то, что дано и что получено;

2) потери информативности - то, что дано, но не получено из-за

рассеянности, спешки, незнания языка или предмета;

3) бесполезная информация - информационный шум" .

33

Получатель (приёмник) информации также имеет свой тезаурус, который

отличается от тезауруса автора документа, но тоже делится на три части:

1) основная информативность - то, что дано и что получено;

2) простая ассоциативная информативность - то, что автор не дал, но

подразумевал и предполагал дать и получатель сумел извлечь, благодаря

своей квалификации;

3) сложная ассоциативная информативность - то, что автор не дал, не

предполагал

давать,

но

получатель

извлёк.

Без

ассоциативной

информативности, кстати, немыслимо эффективное развитие научных

исследований, равно как и вообще невозможен творческий процесс во

многих других областях человеческой деятельности.

Цифровая оценка информативности осуществляется путём составления двух

списков дескрипторов (от англ. "descry" - распознавать), т.е. значимых слов

или словосочетаний, несущих смысловую нагрузку и нередко именуемых

ключевыми словами. В первый список помещаются все дескрипторы

документа, а во второй - дескрипторы получателя, приёмника.

Количество

дескрипторов, повторяющихся в обоих списках, служит показателем

информативности.

Отношение информативности к информационной ёмкости называется

информационной плотностью документа.

Информационная плотность, как правило, меньше единицы, так как в каждом

документе содержится определённое количество бесполезной информации

для данного конкретного потребителя.

Информационная ёмкость и информативность документа зависят от многих

факторов: от языка, стиля (в текстовых документах), от структуры, степени

формализации и т.п.

Одним из важнейших внутренних свойств информации является её

организация, структура. По способу внутренней организации информацию

можно разделить на две группы:

1. логически неупорядоченный набор сведений (данные);

2. логически упорядоченный набор данных.

К примеру, попыткой логически упорядочить имеющуюся основную

информацию в области документоведения является данное учебное пособие,

которое делится на главы, разделы, абзацы. Повышение уровня внутренней

организации любой документированной информации улучшает её

восприятие, экономит время потребителя, влияет на эффективность

принимаемых решений.

Таким образом, изучение информационных свойств

документированной информации, хотя на первый взгляд и может показаться

чем-то достаточно далёким от практики документационного обеспечения

34

управления, в действительности тесно связано с этой практикой.

Рассмотренные теоретические проблемы необходимо принимать во

внимание на многих этапах работы с документами: при использовании

унифицированных текстов; в процессе свёртывания информации либо,

напротив, преднамеренного создания в необходимых случаях её

избыточности; в ходе анализа, критической оценки информации и т.п. Иначе

говоря, свойства документированной информации реализуются как раз в

процессе непосредственной работы с документами, начиная от их создания и

заканчивая архивным хранением и использованием в качестве исторических

источников.

5. Парадоксы теории информации.

Теория информации Хартли-Шеннона родилась как теория поддержки для

технических систем связи. И в этой сфере доказала свою безусловную

полезность. Однако, предложившие ее ученые не могли не понимать, что

вводимая ими количественная мера не отражает всей полноты

существующих информационных процессов, а не только тех процессов, что

характеризуют передачу сигналов по каналам связи. Возможно недаром, у

Хартли информация допускает количественную оценку, хотя ничего не

сказано о том, насколько исчерпывающей такая оценка может быть.

Сравнение количественной физической теории (механики) с теорией

информации, без специальных оговорок, по-видимому незаконно. Механика,

по своему происхождению, имеет дело с измеряемыми величинами массы и

силы, что даёт возможность оперировать категориями материи и энергии. Но,

если по-Винеровски посчитать нетождественность последних двух категорий

информации, то отсюда не очевидно, что теория информации тоже будет

количественной, и последнее нуждается в специальном доказательстве.

Отсутствие в теории информации дефиниции (определения) самой

информации и акцент, который она сделала на количественном исчислении:

1) делают любое её заключение статистическим (см. напр., формулу (1));

2) лишают информацию семантической нагрузки.

Вот несколько примеров, которые это подтверждают:

“Парадокс” с перестановкой букв.

Нести информацию могут лишь

определённые сочетания букв кода (рабочего алфавита, который может быть

считан соответствующим считывающим устройством). Отдельные буквы,

или поставленные как попало буквы, не несут информации, для передачи

которой создан канал связи. Между тем расчёт по формуле (1) может быть

произведён и для одной буквы сообщения! А это явная нелепица. В

35

классической теории информации получается, что слово “буква” несёт

столько же информации, сколько и слово “укваб”, а это бессмыслица.

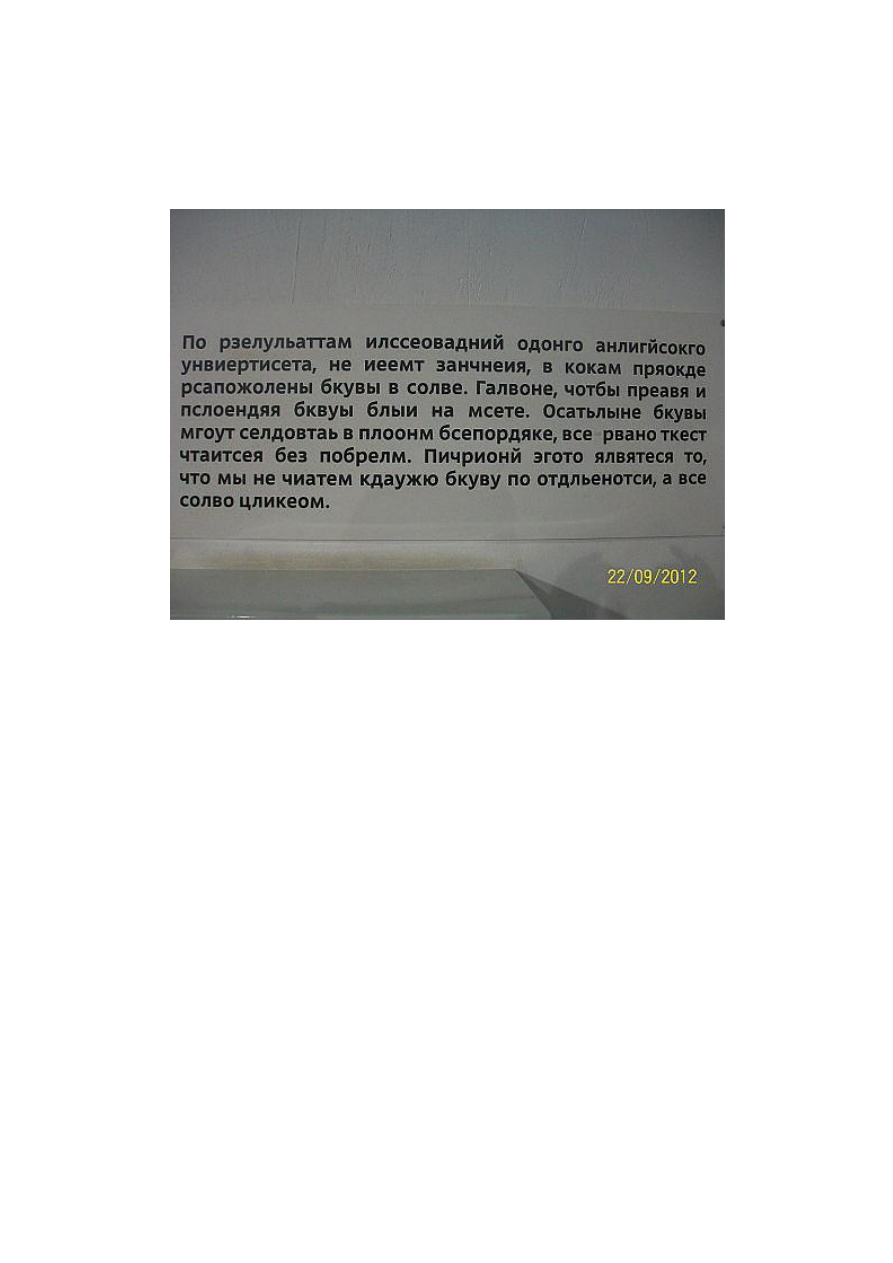

Пример, демонстрирующий данный парадокс представлен на рисунке.

“Парадокс” длинных текстов.

В длинных текстах смысл сообщения может

распределяться неравномерно, однако, согласно записи (1), все элементы

текста можно якобы считать осмысленными в равной мере. Этим

действительно можно было бы удовлетвориться, если бы каналы связи были

абсолютно надёжными, но даже в такой высокоразвитой области техники

связи как радиосвязь существует, например, ситуация помех, то есть

возможной утери куска передаваемого по каналу текста. И если бы была

справедлива оценка типа (1), то риска потерять почти весь смысл или

большую часть сообщения при этом не существовало бы.

Подобные сложности замечены давно. Ещё в 1963 году В.С. Флейшман

писал, что “возникшая благодаря гениальной интуиции К.Шеннона теория

информации испытывает кризис неадекватности физических представлений

и своего аппарата” [Флейшман В.С. Конструкторские методы оптимального

кодирования каналов с шумами.- М.: Изд. АН СССР, 1963. - 144 с.].

Шенноновская запись и последовавшая за ней теория тем самым “как бы

создали возможность для отождествления двух разных по своей природе

феноменов - информации, как семантики сообщения, и “информации”, как

частоты осуществления какого-либо события, подобного модуляции тока на