Добавлен: 14.06.2023

Просмотров: 271

Скачиваний: 5

Сети прямого распространения не обладают памятью, их выход полностью определяется текущими входами и значениями весов. Реккурентные сети обладают свойствами, сходными с кратковременной человеческой памятью.

Реальная нейронная сеть может содержать один или большее количество слоев нейронов и характеризоваться как однослойная или как многослойная искусственная нейронная сеть. Теоретически число слоев в многослойной сети как и число нейронов в каждом слое может быть произвольным, однако практически оно ограничено ресурсами компьютера или специализированной микросхемы, на которых реализуется искусственная нейронная сеть.

4.1 Однослойные сети

Примером простейшей однослойной ИНС может служить трехнейронный перцептрон (рис. 4.1), На рисунке маленькие круги слева (xi) служат лишь для распределения входных сигналов. Они не выполняют каких - либо вычислений, и поэтому не считаются слоем. Каждый элемент из множества входов Х отдельным весом соединен с каждым искусственным нейроном, и каждый нейрон дает на выход Y взвешенную сумму входов.

Рис.4.1 Однослойный перцептрон

На n входов поступают некие сигналы, проходящие по синапсам на 3 нейрона, образующие единственный слой этой ИНС и выдающие три выходных сигнала:

, j=1...3

Все весовые коэффициенты синапсов одного слоя нейронов можно свести в матрицу W, в которой каждый элемент wij задает величину i-ой синаптической связи j-ого нейрона. Таким образом, процесс, происходящий в ИНС, может быть записан в матричной форме:

Y=F(XW)

где X и Y – соответственно входной и выходной сигнальные векторы, F(W) – активационная функция, применяемая поэлементно к компонентам вектора W.

Одной из первых искусственных сетей, способных к восприятию (перцепции) и формированию реакции на воспринятый стимул, явился перцептрон Розенблатта (1957). Персептрон (рис.4.2)рассматривался Розенблаттом не как конкретное техническое вычислительное устройство, а как модель работы мозга.

Рис. 4.2. Элементарный персептрон Розенблатта

Простейший классический персептрон содержит нейрободобные элементы трех типов, назначение которых соответствует нейронам рефлекторной нейронной сети. S-элементы формируют сенсорный слой (входы), принимающий двоичные сигналы от внешнего мира. Затем сигналы поступают в ассоциативный слой (A-элементы). Для упрощения изображения часть связей от входных S-клеток к A-клеткам не показана. Только ассоциативные элементы, представляющие собой формальные нейроны, выполняют нелинейную обработку информации и имеют изменяемые веса связей. R-элементы с фиксированными весами формируют сигнал реакции персептрона на входной стимул.

Розенблатт называл такую нейронную сеть трехслойной, однако в современной терминологии, такая сеть обычно называется однослойной, так как имеет только один слой нейропроцессорных элементов.

Нейронная сеть Коско (рис.4.3) или двунаправленная ассоциативная память (ДАП) — это однослойная нейронная сеть с обратными связями, базирующаяся на двух идеях: адаптивной резонансной теории Стефана Гросбера и модели нейронной сети Хопфилда.

Рис.4.3 Нейронная сеть Коско

В нейронной сети Коско входной вектор поступает на один набор нейронов, а соответствующий выходной вектор вырабатывается на другом наборе нейронов. Двунаправленная ассоциативная память способна к обобщению, вырабатывая правильные реакции. ДАП устойчива к искаженным входам, а также реализуются адаптивные версии нейронной сети Коско, которые выделяют эталонный образ из зашумленных экземпляров.

4.2 Многослойные сети

Существуют различные классификации многослойных нейронных сетей в зависимости от признака. Классифицируя нейронные сети по топологии, можно выделить три основных типа таких сетей: полносвязные сети ( рис. 4.4, а); многослойные или слоистые сети (рис. 4.4, б) слабосвязные сети (рис. 4.4, в)

Рис. 4.4. Архитектуры нейронных сетей: а – полносвязная сеть, б – многослойная сеть с последовательными связями, в – слабосвязные сети

Полносвязные сети представляют собой ИНС, каждый нейрон которой передает свой выходной сигнал остальным нейронам, в том числе и самому себе (рис. 4.4-а). Все входные сигналы подаются всем нейронам. Выходными сигналами сети могут быть все или некоторые выходные сигналы нейронов после нескольких тактов функционирования сети.

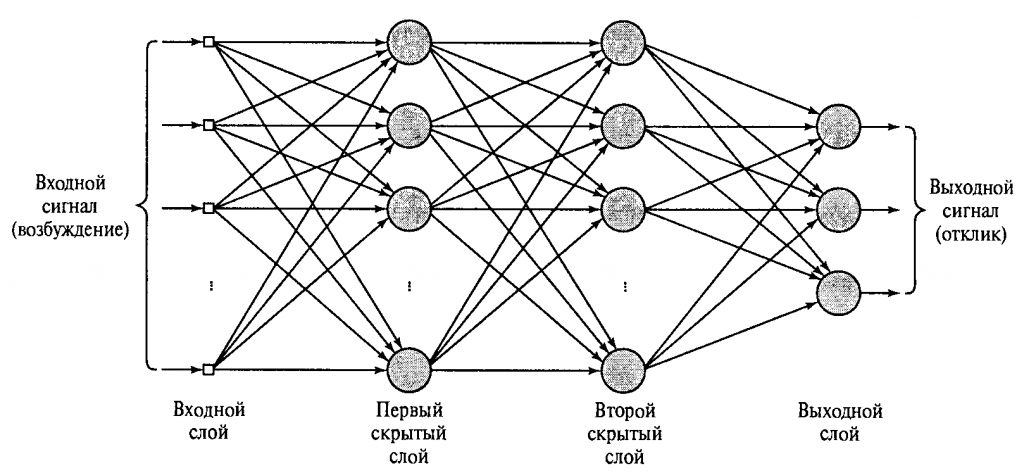

В многослойных (или многосвязных) сетях нейроны объединяются в слои. Слой содержит совокупность нейронов с общими входными сигналами. Число нейронов в каждом слое может быть любым и никак не связано с количеством нейронов в других слоях. Внешние входные сигналы подаются на входы нейронов первого слоя (входной слой часто нумеруют как нулевой). Выходами сети являются выходные сигналы последнего слоя. Вход нейронной сети можно рассматривать как выход «нулевого слоя» вырожденных нейронов, которые служат лишь в качестве распределительных точек, суммирования и преобразования сигналов здесь не производится. Кроме входного и выходного слоев в многослойной нейронной сети есть один или несколько промежуточных (скрытых) слоев.

Связи от выходов нейронов некоторого слоя q к входам нейронов следующего слоя (q + 1) называются последовательными.

В свою очередь, среди слоистых сетей выделяют следующие типы.

Сети без обратных связей (прямого распространения). В таких сетях нейроны входного слоя получают входные сигналы, преобразуют их и передают нейронам 1-го скрытого слоя, далее сигнал срабатывается 1-м скрытым слоем и так далее до последнего слоя, который дает выходные сигналы (рис. 4.4-б). Обычно каждый выходной сигнал q-го слоя подается на вход всех нейронов (q+l)-го слоя; однако возможено соединение q-го слоя с произвольным (q+р)-м слоем.

Сети с обратными связями. Это сети, у которых информация с последующих слоев передается на предыдущие. В качестве примера сетей с обратными связями можно рассматривать так называемые частично-рекуррентные сети Элмана и Жордана (рис.4.5).

Рис. 4.5 Частично-рекурентные сети: а – Элмана; б – Жордана

Слабосвязные сети (нейронные сети с локальными связями) представляют собой слоистые сети с небольшим количеством связей (рис 1-в).

Еще одна классификация делит искусственные нейронные сети на синхронные и асинхронные. Первые - в каждый такт времени свое состояние меняет лишь один нейрон. Во втором случае состояние меняется сразу у целой группы нейронов, как правило, у всего слоя. Алгоритмически ход времени в искусственных нейронных сетях задается итерационным выполнением однотипных действий в нейронах.

Многослойные нейронные сети (рис.4.6) обладают гораздо большими возможностями, чем однослойные. В многослойной сети выход одного слоя является входом для другого слоя. Такие многослойные сети приводят к увеличению вычислительной мощности сети если активационные функции для разных слоев различны и не линейны.

Рис.4.6 Многослойная нейронная сеть

Однако, если многослойная нейронная сеть прямого распространения будет иметь только линейные активационные функции, то такие многослойные сети не могут привести к увеличению вычислительной мощности по сравнению с однослойной сетью. Вычисление выхода слоя сводится в умножении входного вектора на первую весовую матрицу с последующим умножением результирующего вектора на вторую весовую матрицу и т.д. Рассмотрим многослойную нейронную сеть прямого распространения с линейной активационной функцией на примере двухслойной сети (рис 4.7).

Рис. 4.7. Двухслойная нейронная сеть.

Если активационная функция линейна для каждого слоя, то вычисление выхода слоя заключается в умножении входного вектора на первую весовую матрицу с последующим умножением результирующего вектора на вторую весовую матрицу, то Y=F(XW1(W2))=F(X(W1W2)) Значит, двухслойная линейная сеть эквивалентна одному слою. Это показывает, что двухслойная линейная сеть эквивалентна одному слою с весовой матрицей, равной произведению двух весовых матриц. Следовательно многослойные сети с линейной активационной функцией не приводят к увеличению вычислительной мощности по сравнению с однослойной сетью, любая многослойная линейная сеть может быть заменена эквивалентной однослойной сетью.

Множество рекуррентных нейронных сетей гораздо шире и сложнее по своему устройству множества других нейронных сетей. Их поведение описывается дифференциальными или разностными уравнениями, как правило, первого порядка. Что расширяет область применения рекуррентных нейросетей. Сеть организована так, что каждый нейрон получает входную информацию от других нейронов, а иногда и от самого себя, и от окружающей среды. Этот тип сетей имеет важное значение для моделирования нелинейных динамических систем. Среди рекуррентных сетей выделяются сети Хопфилда, Элмана–Жордана и сети Кохонена.

Сеть Хопфилда - это полносвязная нейронная сеть, состоящая из N искусственных нейронов. Аксон каждого нейрона сети связан с дендритами остальных нейронов, образуя обратную связь с симметричной матрицей связей. В процессе работы динамика такой сети сходится к одному из заранее определенных положений равновесия. Сеть Хопфидлда (рис. 4.8) может быть использована для решения некоторых задач оптимизации, а также как автоассоциативная память или фильтр. В отличие от многих нейронных сетей, работающих до получения ответа через определённое количество итераций, сеть Хопфилда работает до достижения равновесия, когда при равновесии получают выходной образ, где начальное состояние является входным образом.

Рис.4.8 Архитектура нейронной сети Хопфилда

Каждый нейрон может находиться в одном из 2-х состояний(«возбужденном» и «заторможенном»):

S(t) ϵ{-1;+1}

где S(t) — состояние нейрона в момент t. «Возбуждению» нейрона соответствует +1, а «торможению» -1. Дискретность состояний нейрона отражает нелинейный, пороговый характер его функционирования (принцип «все или ничего»).

Динамика состояния во времени i-ого нейрона в сети из N нейронов описывается дискретной динамической системой:

где Ji,j— матрица весовых коэффициентов, описывающих взаимодействие дендритов i-ого нейрона с аксонами j-ого нейрона.

Отметчу, что Ji,j=0, i=1,…,N и случай не рассматриваются.

Нейронную сеть можно использовать в качестве ассоциативной памяти, а также для обработки неупорядоченных и упорядоченных во времени или пространстве образцов. Нейронная сеть Хопфилда устроена так, что её отклик на запомненные m {\displaystyle m} эталонные «образы» составляют сами эти образы, а если образ немного исказить и подать на вход, он будет восстановлен и в виде отклика будет получен оригинальный образ. Таким образом, сеть Хопфилда осуществляет коррекцию ошибок и помех. Эта модель является наиболее распространенной математической моделью в нейронауке, что обусловлено ее простотой и наглядностью. Сеть Хопфилда показывает, каким образом может быть организована память в сети из элементов, которые не являются очень надежными. Экспериментальные данные показывают, что при увеличении количества вышедших из строя нейронов до 50%, вероятность правильного ответа все равно крайне близка к 100%.

Развитием нейронной сети Хопфилда является - Нейронная сеть Хэмминга. Это вид нейронной сети, которую используют для классификации бинарных векторов, основным критерием в которой является расстояние Хэмминга. В отличие от сети Хопфилда, выдаёт не сам образец, а его номер. Сеть была предложена с 1987 году Ричардом Липпманом.

Рис. 4.9 Сеть Элмана

Нейронная сеть Элмана (рис. 4.9, рис 4.10) представляет из себя трёхслойную нейронную сеть, вход, выход и скрытый слой. Дополнительно к сети добавлен слой «контекстных нейронов». Скрытый слой соединён с контекстным блоком с фиксированным весом, равным единице. С каждым тактом времени на вход поступает информация, которая проходит прямой ход к выходному слою в соответствии с правилами обучения. Благодаря фиксированным обратным связям в контекстном блоке сохраняются предыдущие значения скрытого слоя (до того как скрыты слой поменяет значение в процессе обучения). Таким образом сеть сохраняет своё состояние, что может использоваться в предсказании последовательностей, выходя за пределы мощности многослойного перцептрона.