ВУЗ: Не указан

Категория: Не указан

Дисциплина: Не указана

Добавлен: 11.12.2023

Просмотров: 41

Скачиваний: 1

ВНИМАНИЕ! Если данный файл нарушает Ваши авторские права, то обязательно сообщите нам.

ТПР

Семинар

АЛГОРИТМ «ДИСКРИМИНАНТНАЯ ФУНКЦИЯ»

Назначение — решение задач распознавания в ситуациях, когда в материале обучения представлены объекты

Постановка задачи. В исходных данных, представленных в виде ТОС, присутствуют представители всех образов. Для каждого объекта указана его принадлежность к образу. В процессе распознавания определяется принадлежность объектов экзамена к одному из образов.

Метод решения задачи. Этот метод основан на предположении, что объекты, составляющие каждый из образов, многомерно нормально распределены. Мы опираемся на эталонные объекты. Теоретически разделяются:

— линейный дискриминантный анализ, когда матрицы ковариации для разных образов равны;

— квадратичный дискриминантный анализ, когда матрицы ковариации для разных объектов различны.

Линейный дискриминантный анализ

Рассмотрим случай, когда в МО имеется два образа. Оказывается, что при равных ковариационных матрицах поверхностью, с одной стороны от которой больше вероятность принадлежности к одному из образов, а с другой к другому (критерий Байеса) является гиперплоскость, т. е. линейная поверхность размерности

В данном случае эта поверхность вычисляется следующим образом:

Формула (4.1) называется уравнением линейной дискриминантной функции, где

—

;

;Коэффициенты ковариации вычисляются следующим образом:

где m — математическое ожидание по к-ому свойству.

Коэффициенты ковариации тесно связаны с коэффициентом корреляции:

Дисперсия

Дискриминантная плоскость разбивает все пространство на две части. При этом точки пространства, относимые к 1-му образу, при подставлении своих координат в дискриминантную функцию дадут

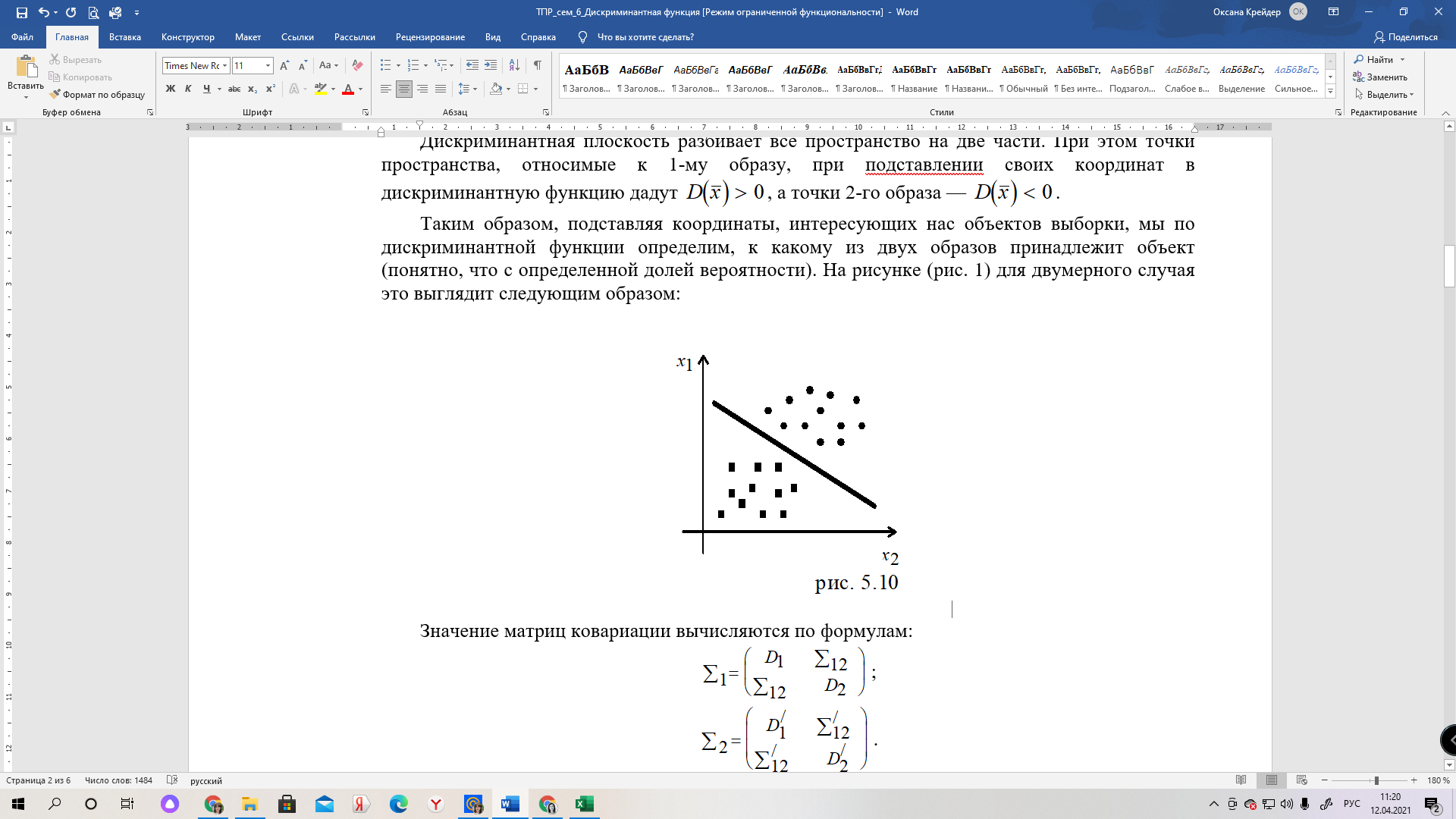

Таким образом, подставляя координаты, интересующих нас объектов выборки, мы по дискриминантной функции определим, к какому из двух образов принадлежит объект (понятно, что с определенной долей вероятности). На рисунке (рис. 1) для двумерного случая это выглядит следующим образом:

Рис.1.

Значение матриц ковариации вычисляются по формулам:

;

; .

.Есть параметр, говорящий о качестве разбиения с помощью дискриминантной функции — это расстояние Махаланобиса:

Разбиение тем лучше, чем больше

Квадратичный дискриминантный анализ

Был рассмотрен случай, когда матрицы ковариации для разных образов равны, и для распознавания использовалась линейная дискиминантная функция. Теперь рассмотрим ситуацию, когда матрицы ковариаций разных образов не совпадают. Для различных ковариационных матриц байесовский критерий предлагает строить квадратичную дискриминантную функцию. Однако, на практике ее строят чрезвычайно редко, поскольку никогда нельзя с точностью сказать равны или нет ковариационные матрицы. Мы ведь имеем только оценки, так как работаем не со всей генеральной совокупностью объектов, а только с выборкой из нее. Поэтому обычно вычисляют усредненную ковариационную матрицу для двух образов:

где

После этого применяется линейный дискриминантный анализ.

Распознавание с отказами. Пусть имеется

(т. е. известны эталоны для этих образов). Тогда можно построить линейную дискриминантную функцию для любой пары образов:

где

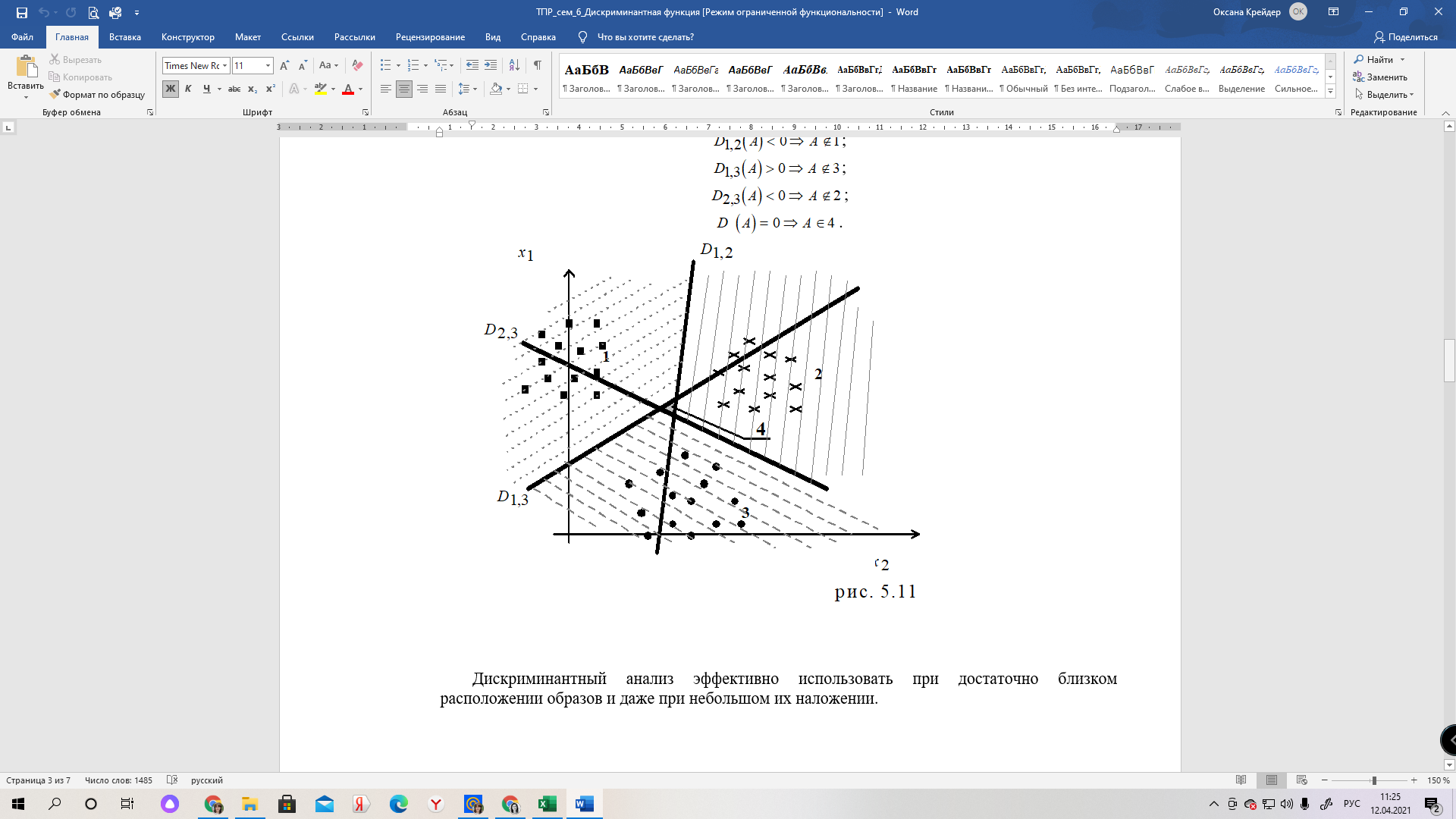

Посмотрим, как это выглядит на графике (рис. 4.11), где

D — гиперплоскости;

1, 2, 3 — образы;

4 — область отказа.

В область отказа попадают такие точки, для которых невозможно определить принадлежность к одному из образов. Другими словами, точка отказа — это такая точка, координаты которой при подставлении в дискриминантную функцию дают следующие значения:

.

.Рис.2.

Дискриминантный анализ эффективно использовать при достаточно близком расположении образов и даже при небольшом их наложении.

Рис.3.

Практика показала, что дискриминантный анализ хорошо работает и для случая, когда нет многомерного нормального распределения. При этом необходимо, чтобы распределение по каждому образу было все-таки симметрично и унимодально. Правда, при этом алгоритм уже нельзя рассматривать как статистический, а можно говорить об эвристическом алгоритме распознавания образов.

П р и м е р.

После отбора в модельном агентстве девушек делят на две группы: для Модельера№1 и для Модельера№2. Распределение происходит при условии, что для Модельера№1 необходимы девушки с объемом талии 50—60 см и весом от 40—50 кг, а для Модельера№2 требуются девушки с объемом талии 60—70 см и весом 50—60 кг.

Таким образом, мы имеем два образа: Модельер№1 и Модельер№2. Для каждого образа измерены два свойства: объем талии и вес. Нам известна часть представителей из этих образов и значение их свойств (табл. 2). Требуется отнести объекты МЭ к одному из образов.

Табл.2

| Образ девушек для Модельера№1 | | Образ девушек для Модельера№2 | | Материал экзамена | |||||||||

| | Талия | Вес | N | | | Талия | Вес | N | | | Талия | Вес | N |

| 1 | 51 | 47 | 1 | | 16 | 64 | 51 | 2 | | 41 | 68 | 46 | 0 |

| 2 | 56 | 44 | 1 | | 17 | 63 | 54 | 2 | | 42 | 67 | 47 | 0 |

| 3 | 56 | 43 | 1 | | 18 | 63 | 52 | 2 | | 43 | 51 | 51 | 0 |

| 4 | 57 | 47 | 1 | | 19 | 69 | 59 | 2 | | 44 | 57 | 44 | 0 |

| 5 | 59 | 47 | 1 | | 20 | 62 | 54 | 2 | | 45 | 60 | 56 | 0 |

| 6 | 55 | 47 | 1 | | 21 | 69 | 52 | 2 | | 46 | 58 | 45 | 0 |

| 7 | 56 | 47 | 1 | | 22 | 69 | 52 | 2 | | 47 | 58 | 46 | 0 |

| 8 | 54 | 44 | 1 | | 23 | 64 | 58 | 2 | | 48 | 68 | 49 | 0 |

| 9 | 56 | 43 | 1 | | 24 | 60 | 52 | 2 | | 49 | 69 | 55 | 0 |

| 10 | 60 | 50 | 1 | | 25 | 61 | 50 | 2 | | 50 | 69 | 55 | 0 |

| 11 | 52 | 50 | 1 | | 26 | 61 | 58 | 2 | | 51 | 53 | 44 | 0 |

| 12 | 54 | 45 | 1 | | 27 | 60 | 55 | 2 | | 52 | 66 | 49 | 0 |

| 13 | 57 | 44 | 1 | | 28 | 70 | 59 | 2 | | 53 | 69 | 45 | 0 |

| 14 | 56 | 41 | 1 | | 29 | 67 | 57 | 2 | | 54 | 54 | 59 | 0 |

| 15 | 57 | 48 | 1 | | 30 | 63 | 53 | 2 | | 55 | 58 | 60 | 0 |

| | | | | | 31 | 64 | 54 | 2 | | 56 | 57 | 41 | 0 |

| | | | | | 32 | 70 | 57 | 2 | | 57 | 60 | 52 | 0 |

| | | | | | 33 | 68 | 50 | 2 | | 58 | 50 | 54 | 0 |

| | | | | | 34 | 62 | 59 | 2 | | 59 | 66 | 57 | 0 |

| | | | | | 35 | 68 | 59 | 2 | | 60 | 55 | 52 | 0 |

| | | | | | 36 | 70 | 54 | 2 | | | | | |

| | | | | | 37 | 61 | 59 | 2 | | | | | |

| | | | | | 38 | 69 | 57 | 2 | | | | | |

| | | | | | 39 | 66 | 52 | 2 | | | | | |

| | | | | | 40 | 69 | 53 | 2 | | | | | |