Файл: Экзаменационный билет 1 Вопрос Научно методический анализ и методика формирования понятия вес тела.docx

Добавлен: 10.11.2023

Просмотров: 40

Скачиваний: 2

ВНИМАНИЕ! Если данный файл нарушает Ваши авторские права, то обязательно сообщите нам.

Можно выделить следующие подходы к определению информации:

1) традиционный (обыденный) – используется в информатике: Информация – это сведения, знания, сообщения о положении дел, которые человек воспринимает из окружающего мира с помощью органов чувств (зрения, слуха, вкуса, обоняния, осязания);

2) вероятностный – используется в теории об информации: Информация – это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределённости и неполноты знаний.

Так же, выделяются определения понятия «Информация» в зависисмости от сферы деятельности человека. Рассмотрим подробнее эти определения, которые представленны ниже в таблице.

| Сфера деятельности | Определение понятия «Информация» |

| В быту | Информация – сведения об окружающем мире и протекающих в нем процессах, воспринимаемые человеком или специальными устройствами |

| В технике | Информация – сообщения, передаваемые в форме знаков или сигналов |

| В кибернетике | Информация – часть знаний, которая используется для ориентирования, активного действия, управления, то есть в целях развития системы |

| В семантике | Информация – сведения, обладающие новизной |

Таким образом, проанализировав предложенные определения, можно сделать вывод о том, что в общем случаи Информация – это осознанные сведения об окружающем мире, которые являются объектом хранения, преобразования, передачи и использования.

Любая информация всегда связана с каким-либо материальным предметом, который является ее носителем. Такими носителями могут быть подходящие материальные предметы, вещества в разных состояниях, машинные носители. Передается информация с помощью сигналов. Сигнал — это физический процесс с информационным значением. Они могут дискретными или непрерывными. Непрерывным называется сигнал, который постоянно меняется во времени по амплитуде. Дискретный сигнал принимает конечное число значений. Непрерывный сигнал используется в телевизионном и радиовещании, телефонной связи, а дискретный передает символическую, текстовую информацию.

Виды информации классифицируются по следующим признакам:

-

По области возникновения:

— элементарная — отражает все, что происходит с неодушевленной природой;

— биологическая — отражает все, что происходит с миром животных и растений;

— социальная — отражает процессы социума людей.

-

По способу передачи и восприятию:

— визуальная — все, что можно увидеть;

— аудиальная — все, что можно услышать;

— тактильная — все, что можно ощутить;

— органолептическая — все, что можно попробовать и почувствовать в воздухе;

— машинная — все что выдается и воспринимается средствами ЭВМ.

-

По общественному назначению:

— массовая — политическая, общественная, популярная;

— специальная — научная, техническая;

— личная — индивидуальная.

-

По форме представления — графическая, числовая, текстовая, звуковая и видеоинформация.

Как и всякий объект, информация обладает свойствами. Характерной отличительной особенность информации от других объектов природы и общества, является дуализм: на свойства информации влияют как свойства исходных данных, составляющих ее содержательную часть, так и свойства методов, фиксирующих эту информации. С точки зрения информатики наиболее важными представляются следующие общие качественные свойства: объективность, достоверность, полнота, точность, актуальность, полезность, ценность, своевременность, понятность, доступность, краткость и пр.

Объективность. Объективный – существующий вне и независимо от человеческого сознания. Информация – это отражение внешнего объективного мира. Информация объективна, если она не зависит от методов ее фиксации, чьего-либо мнения, суждения. Пример. Сообщение «На улице тепло» несет субъективную информацию, а сообщение «На улице 220С» – объективную, но с точностью, зависящей от погрешности средства измерения. Объективную информацию можно получить с помощью исправных датчиков, измерительных приборов. Отражаясь в сознании конкретного человека, информация перестает быть объективной, так как, преобразовывается (в большей или меньшей степени) в зависимости от мнения, суждения, опыта, знаний конкретного субъекта.

Достоверность информации. Информация достоверна, если она отражает истинное положение дел. Объективная информация всегда достоверна, но достоверная информация может быть как объективной, так и субъективной. Достоверная информация помогает принять нам правильное решение. Недостоверной информация может быть по следующим причинам:

♦ преднамеренное искажение (дезинформация) или непреднамеренное искажение субъективного свойства;

♦ искажение в результате воздействия помех («испорченный телефон») и недостаточно точных средств ее фиксации.

Полнота информации. Информацию можно назвать полной, если ее достаточно для понимания и принятия решений. Неполная информация может привести к ошибочному выводу или решению.

Точность информации определяется степенью ее близости к реальному состоянию объекта, процесса, явления и т. п.

Актуальность информации – важность для настоящего времени, злободневность, насущность. Только вовремя полученная информация может быть полезна.

Полезность(ценность) информации. Полезность может быть оценена применительно к нуждам конкретных ее потребителей и оценивается по тем задачам, которые можно решить с ее помощью.

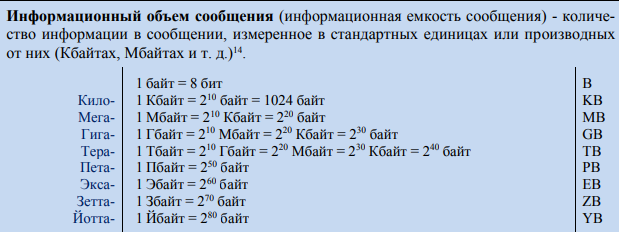

В вычислительной технике вся обрабатываемая и хранимая информация вне зависимости от ее природы представлена в двоичной форме (с использованием алфавита, состоящего всего из двух символов 0 и 1). Это позволило ввести две стандартные единицы измерения: бит (binary digit) и байт (bate). Бит – минимальная единица измерения информации, которая представляет собой двоичный знак двоичного алфавита {0;1}. Байт – единица количества информации в СИ, представляющая собой восьмиразрядный двоичный код, с помощью которого можно представить один символ. Информационный объем сообщения (информационная емкость сообщения) - количество информации в сообщении, измеренное в стандартных единицах или производных от них

В информатике используются различные подходы к измерению информации:

Алфавитный (кибернетический, объемный) подход к измерению информации не связывает кол-во информации с содержанием сообщения. Кол-во информации зависит от объема текста и мощности алфавита.

Алфавит – конечное множество различных знаков, символов, которые используются для записи. N при алфавитном подходе называют мощностью алфавита.

Информационная ёмкость каждого знака зависит от количества знаков в алфавите. Следовательно, каждый из N символов несёт i бит информации. 2i = N

Количество информации: I = k × i, где k - количество символов в тексте сообщения

Алфавитный подход является объективным способом измерения информации и подходит для работы технических устройств.

Минимальная мощность алфавита, пригодного для передачи информации, равна 2. Такой алфавит называется двоичным алфавитом. Информационный вес символа в двоичном алфавите легко определить. Поскольку 2i = 2, то i = 1 бит. Итак, один символ двоичного алфавита несет 1 бит информации.

Содержательный (энтропийный, вероятностный) подход к измерению информации. Этот подход основан на том, что факт получения информации всегда связан с уменьшением неопределенности (энтропии) системы. Сообщение несет информацию для человека, если содержащиеся в нем сведения являются для него новыми и понятными. Если сообщение не информативно, то количество информации с точки зрения человека = 0.

Пример: вузовский учебник по высшей математике содержит знания, но они не доступны 1-класснику.

Количество информации - это мера уменьшения неопределенности. В качестве меры неопределенности вводится энтропия Н, а количество информации равно: I = Hapr – Haps, где Hapr – априорная энтропия о состоянии исследуемой системы или процесса; Haps – апостериорная энтропия.

Апостериори (от лат. aposteriori – из последующего) – происходящее из опыта (испытания, измерения). Априори (от лат. apriori – из предшествующего) – понятие, характеризующее знание, предшествующее опыту (испытанию) и независимое от него.

В случае, когда в ходе испытания имевшаяся неопределенность снята (получен конкретный результат, то есть Haps = 0), количество полученной информации совпадает с первоначальной энтропией.

Так, американский инженер Р. Хартли (1928 г.) процесс получения информации рассматривает как выбор одного сообщения из конечного наперёд заданного множества из N равновероятных сообщений, а количество информации I, содержащееся в выбранном сообщении, определяет как двоичный логарифм N.

| Формула Хартли: H= log2N. |

Приведем примеры равновероятных сообщений:

1. при бросании монеты: "выпала решка", "выпал орел";

2. на странице книги: "количество букв чётное", "количество букв нечётное".

Определим теперь, являются ли равновероятными сообщения "первой выйдет из дверей здания женщина" и "первым выйдет из дверей здания мужчина". Однозначно ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, например, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины.

Для задач такого рода американский учёный Клод Шеннон предложил в 1948 г. другую формулу определения количества информации, учитывающую возможную неодинаковую вероятность сообщений в наборе.

| Формула Шеннона: I = – (p1 log2 p1 + p2 log2 p2 + . . . + pN log2 pN ), где pi — вероятность того, что именно i-е сообщение выделено в наборе из N сообщений. N – количество сообщений |

Если вероятности p1, ..., pN равны, то каждая из них равна 1/N, и формула Шеннона превращается в формулу Хартли.

Формы и способы представления информации

Символьная форма представления информации является наиболее простой, в ней каждый символ имеет какое-то значение. Например: красный свет светофора, показатели поворота на транспортных средствах, различные жесты, сокращения и обозначения в формулах. Текстовая форма представления информации является более сложной. Эта форма предусматривает, что содержание сообщения передается не через отдельные символы (цифры, буквы, знаки), а их сочетанием, порядком размещения. Последовательно расположены символы образуют слова, которые в свою очередь могут образовывать предложения. Текстовая информация используется в книгах, брошюрах, газетах, журналах и т. Графическая форма представления информации, как правило, имеет наибольший объем. К этой форме относятся фотографии, картины, чертежи, графики и тому подобное. Графическая форма более информативна. Видимо, поэтому, когда берем в руки новую книгу, то первым делом ищем в ней рисунки, чтобы создать о ней наиболее полное впечатление. Информацию можно подавать одним из способов: буквами и знаками, жестами, нотами музыки, рисунками, картинами, скульптурами, звукозаписью, видеозаписью, кинофильмами и тому подобное. Информация может быть в виде непрерывных (аналоговых) и дискретных (цифровых) сигналов. Информация в аналоговом виде меняет свое значение постепенно (показатели термометра, часов со стрелками, спидометра и т.д.). Информация в дискретном виде меняет свое значение с определенным шагом (показатели электронных часов, весы с гирями, подсчет количества предметов и т.п.).

Человек существует в информационном пространстве, он постоянно получает информацию из окружающей среды с помощью органов чувст, хранит ее в своей памяти, анализиует с помощью мышления и обменивается информацией с другими людьми. Таким образом, были выделены действия (последовательность операций), совершаемые над информацией, которые называются информационными процессами.