Файл: Направление подготовки 09. 03. 04 Программная инженерия.docx

ВУЗ: Не указан

Категория: Не указан

Дисциплина: Не указана

Добавлен: 29.10.2023

Просмотров: 215

Скачиваний: 2

ВНИМАНИЕ! Если данный файл нарушает Ваши авторские права, то обязательно сообщите нам.

Выводы

В данном разделе было описано проведение экспериментального исследования предлага- емого модуля генерации аудиоинформации на основе видеозаписи, а именно:

-

Описаны данные, используемые в эксперименте. -

Описана методика проведение эксперимента. -

Описаны результаты проведения эксперимента.

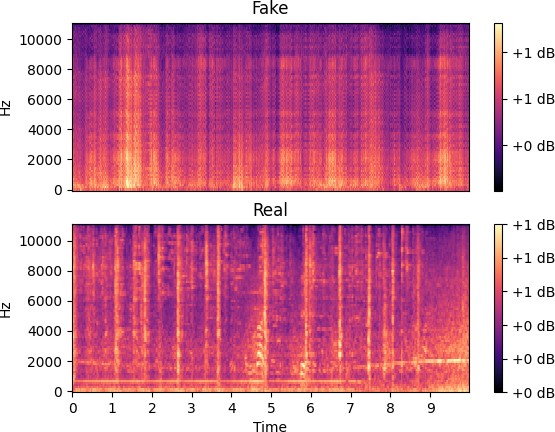

Рис. 4.8 – Тест генерации мел-спектрограммы видео 1

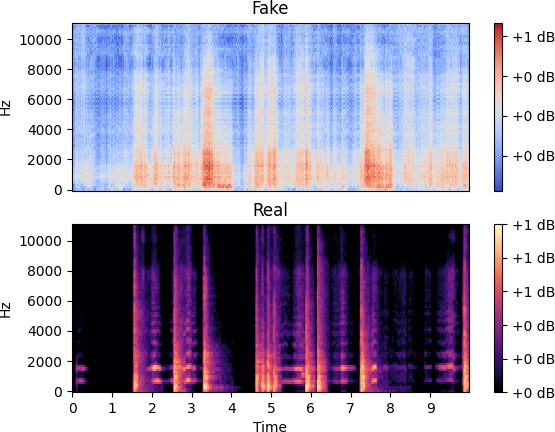

Рис. 4.9 – Тест генерации мел-спектрограммы видео 2

Заключение

В процессе работы была проанализирована проблемная область генерации аудиоинформа- ции на основе видеозаписи - были описаны существующие подходы к решению задач и при- меняемые технологии. В качестве подхода для дальнейшей реализации было выбрано созда- ние нейросетевого модуля, использующего технологии сверточных, рекуррентных и генеративно- созтязательный нейронных сетей.

Также был разработан метод генерации аудиоинформации на основе видеозаписи, осно- ванный на технологии нейронных сетей - была описана логика взаимодействие нейросетевых компонентов и архитектура каждого из них.

Была описана общая архитектуры модуля, которая включает в себя обрабатывающий ком- понент, реализующий обработку входных данных в формат, необходимый для нейросетевого компонента и нейросетевой компонент, выполняющий основную задачу

модуля; описан ход разработки и применяемые инструментальные средства.

Также была приведена экспериментальная оценка эффективности предлагаемого модуля - описан процесс проведения и ход эксперимента, продемонстрированы основные результаты. Предполагаемыми направлениями для будущей работы являются повышение эффектив-

ности работы модуля и интеграция с другими программными компонентами.

Список литературы

-

Aytar Y., VondrickC., TorralbaA.Soundnet: Learning sound representations from unlabeled video // Advances in Neural Information Processing Systems. — 2016. -

Generating Visually Aligned Sound from Videos / P. Chen [и др.]. — 2020. — eprint: arXiv: 2008.00820. -

Visual to Sound: Generating Natural Sound for Videos in the Wild / Y. Zhou [и др.]. — 2017. — eprint: arXiv:1712.01393. -

Deep Audio-Visual Speech Recognition / T. Afouras [и др.]. — 2018. — DOI: 10.1109/TPAMI. 2018.2889052. — eprint: arXiv:1809.02108. -

Relation Attention for Temporal Action Localization / P. Chen [и др.] // IEEE Transactions on Multimedia. — 2020. — Т. 22, № 10. — С. 2723—2733. — DOI: 10.1109/TMM.2019.2959977. -

Breaking Winner-Takes-All: Iterative-Winners-Out Networks for Weakly Supervised Temporal Action Localization / R. Zeng [и др.] // IEEE Transactions on Image Processing. — 2019. — Т. 28,

№ 12. — С. 5797—5808. — DOI: 10.1109/TIP.2019.2922108.

-

Graph Convolutional Networks for Temporal Action Localization / R. Zeng [и др.]. — 2019. — eprint: arXiv:1909.03252. -

Closed-Loop Matters: Dual Regression Networks for Single Image Super-Resolution / Y. Guo [и др.] // 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). — IEEE, 06.2020. — DOI: 10.1109/cvpr42600.2020.00545. — URL: https://doi.org/10.1109/ cvpr42600.2020.00545. -

WaveNet: A Generative Model for Raw Audio / A. van den Oord [и др.] // Arxiv. — 2016. — URL:

https://arxiv.org/abs/1609.03499.

-

SampleRNN: An Unconditional End-to-End Neural Audio Generation Model / S. Mehri [и др.]. — 2016. — eprint: arXiv:1612.07837. -

Ambient Sound Provides Supervision for Visual Learning / A. Owens [и др.] // Computer Vision – ECCV 2016. — Springer International Publishing, 2016. — С. 801—816. — DOI: 10.1007/978- 3-319-46448-0_48. — URL: https://doi.org/10.1007/978-3-319-46448-0_48. -

Learning Multimodal Dictionaries / G. Monaci [и др.] // IEEE Transactions on Image Processing. — 2007. — Т. 16, № 9. — С. 2272—2283. — DOI: 10.1109/TIP.2007.901813. -

Harwath D., Torralba A., Glass J.Unsupervised Learning of Spoken Language with Visual Context // Advances in Neural Information Processing Systems. Т. 29 / под ред. D. Lee [и др.]. — Curran Associates, Inc., 2016. — URL: https://proceedings.neurips.cc/paper/2016/file/ 82b8a3434904411a9fdc43ca87cee70c-Paper.pdf. -

ArandjelovicR., ZissermanA.Look, Listen and Learn // 2017 IEEE/CVF International Conference on Computer Vision (ICCV). — 10.2017. — С. 609—617. — DOI: 10.1109/ICCV.2017.73. -

The Sound of Pixels / H. Zhao [и др.] // Computer Vision – ECCV 2018. — Springer International Publishing, 2018. — С. 587—604. — DOI: 10.1007/978-3-030-01246-5_35. — URL: https:

//doi.org/10.1007/978-3-030-01246-5_35.

-

The Sound of Motions / H. Zhao [и др.] // 2019 IEEE/CVF International Conference on Computer Vision (ICCV). — 2019. — С. 1735—1744. — DOI: 10.1109/ICCV.2019.00182. -

Music Gesture for Visual Sound Separation / C. Gan [и др.] // 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). — 2020. — С. 10475—10484. — DOI: 10.1109/ CVPR42600.2020.01049. -

Self-supervised Moving Vehicle Tracking with Stereo Sound / C. Gan [и др.]. — 2019. — eprint:

arXiv:1910.11760.

-

Self-Supervised Audio-Visual Co-Segmentation / A. Rouditchenko [и др.]. — 2019. — eprint: arXiv: 1904.09013. -

Look, Listen, and Act: Towards Audio-Visual Embodied Navigation / C. Gan [и др.]. — 2019. — eprint: arXiv:1912.11684. -

Comparing recurrent convolutional neural networks for large scale bird species classification /

G. Gupta [и др.] // Scientific Reports. — 2021. — Авг. — Т. 11, № 1. — DOI: 10.1038/s41598- 021-96446-w. — URL: https://doi.org/10.1038/s41598-021-96446-w.

-

Convolutional Recurrent Neural Networks for Polyphonic Sound Event Detection / E. Çakır [и др.]. — 2017. — DOI: 10.1109/TASLP.2017.2690575. — eprint: arXiv:1702.06286. -

Attention based convolutional recurrent neural network for environmental sound classification /

Z. Zhang [и др.] // Neurocomputing. — 2021. — Т. 453. — С. 896—903. — ISSN 0925-2312. — DOI: https:// doi. org/ 10 . 1016 / j. neucom . 2020 . 08 . 069. — URL: https://www . sciencedirect.com/science/article/pii/S0925231220313618.

-

ШоллеФ.Глубокое обучение на Python. — Санкт-Петербург: Питер, 2019. -

Гафаров Ф., Галимянов А. Искусственные нейронные сети и их приложения. — Издатель- ство Казанского университета, 2018. -

HochreiterS., SchmidhuberJ.Long Short-Term Memory // Neural Computation. — 1997. — Нояб. — Т. 9, № 8. — С. 1735—1780. — DOI: 10.1162/neco.1997.9.8.1735. — URL: https://doi. org/10.1162/neco.1997.9.8.1735. -

LiptonZ.C., BerkowitzJ., ElkanC.A Critical Review of Recurrent Neural Networks for Sequence Learning. — 2015. — eprint: arXiv:1506.00019. -

Plug & Play Generative Networks: Conditional Iterative Generation of Images in Latent Space /

A. Nguyen [и др.]. — 2016. — eprint: arXiv:1612.00005.

-

Generative Adversarial Text to Image Synthesis / S. Reed [и др.]. — 2016. — eprint: arXiv:1605. 05396. -

Generative Adversarial Networks / I. Goodfellow [и др.] // Advances in Neural Information Processing Systems. — 2014. — Июнь. — Т. 3. — DOI: 10.1145/3422622. -

АфонскийА. А., ДьяконовВ. П. Цифровые анализаторы спектра, сигналов и логики / под ред. В. П. Дьяконовa. — М. : СОЛОН-Пресс, 2009. -

Слюсар В. Современные тренды радиорелейной связи // Технологии и средства связи. — 2014. — Т. 3. — С. 32—36. -

StevensS.S., VolkmannJ., NewmanE.B.A Scale for the Measurement of the Psychological Magnitude Pitch // The Journal of the Acoustical Society of America. — 1937. — Янв. — Т. 8, № 3. — С. 185—

190. — DOI: 10.1121/1.1915893. — URL: https://doi.org/10.1121/1.1915893.

-

YFCC100M: The New Data in Multimedia Research / B. Thomee [и др.] // Communications of the ACM. — 2016. — Т. 59, № 2. — С. 64—73. — URL: http://cacm.acm.org/magazines/2016/2/ 197425-yfcc100m/fulltext. -

Audio Set: An ontology and human-labeled dataset for audio events / J. F. Gemmeke [и др.] // Proc. IEEE ICASSP 2017. — New Orleans, LA, 2017. -

A corpus of audio-visual Lombard speech with frontal and profile views / N. Alghamdi [и др.] // The Journal of the Acoustical Society of America. — 2018. — Июнь. — Т. 143, № 6. — EL523— EL529. — DOI: 10.1121/1.5042758. — URL: https://doi.org/10.1121/1.5042758. -

Looking to listen at the cocktail party / A. Ephrat [и др.] // ACM Transactions on Graphics. — 2018. — Авг. — Т. 37, № 4. — С. 1—11. — DOI: 10.1145/3197517.3201357. — URL: https: