Файл: Учебнометодическое пособие знакомит студентов с основными понятиями о.doc

ВУЗ: Не указан

Категория: Не указан

Дисциплина: Не указана

Добавлен: 12.12.2023

Просмотров: 485

Скачиваний: 2

ВНИМАНИЕ! Если данный файл нарушает Ваши авторские права, то обязательно сообщите нам.

СОДЕРЖАНИЕ

Если же с изменением значения признака x среднее значение признака y не изменяется закономерным образом, но закономерно изменяется другая статистическая характерис-тика (показатели вариации, асимметрии, эксцесса и т.п.), то связь является не корреляционной, а статистической.

Статистическая связь между двумя признаками (переменными величинами) предполагает, что каждый из них имеет случайную вариацию индивидуальных значений относительно средней величины. Если же такую вариацию имеет лишь один из признаков, а значения другого являются строго детерминированными, то говорят лишь о регрессии, но не о статистической (тем более корреляционной) связи.

При анализе динамических рядов можно измерять регрессию уровней ряда урожайности (имеющих случайную изменчивость) на номера лет. Но нельзя говорить о корреляции между ними и применять показатели корреляции с соответствующей им интерпретацией.

Само слово корреляция ввел в употребление в статистику английский биолог и статистик Френсис Гальтон в конце XIX века. Тогда оно писалось как “corelation” (соответствие), но не просто “связь” (relation), а “как бы связь”, т.е. связь, но не в привычной функциональной форме. В науке вообще, а именно в палеонтологии, термин “корреляция” применял еще раньше, в конце XVIII века французский палеонтолог Жорж Кювье. Он ввел даже “закон корреляции” частей и органов животных. “Закон корреляции” помогает восстановить по найденным в раскопках черепу, костям и т.д. облик всего животного и его место в системе: если череп с рогами, то это было травоядное животное, а его конечностями были копыта; если же лапа с когтями - то хищное животное без рогов, но с крупными клыками.

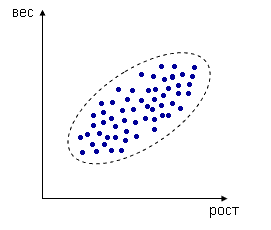

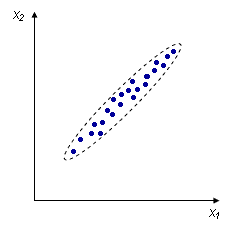

Например, измеряем рост и вес человека, каждое измерение представлено точкой в двумерном пространстве:

Несмотря на то, что величины носят случайный характер, в общем наблюдается некоторая зависимость - величины коррелируют.

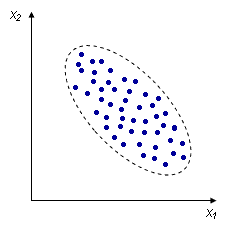

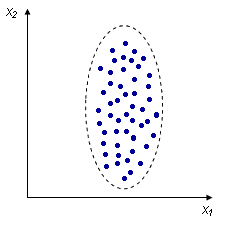

В данном случае это положительная корреляция (при увеличении одного параметра второй тоже увеличивается). Возможны также такие случаи:

| Отрицательная корреляция:  | Отсутствие корреляции:  |

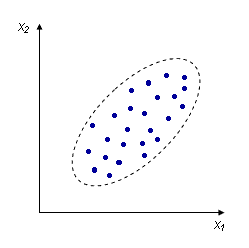

Взаимосвязь между переменными необходимо охарактеризовать численно, чтобы, например, различать такие случаи:

|  |

Корреляционная связь между признаками может возникать различными путями:

-

Важнейший путь - причинная зависимость результативного признака (его вариации) от вариации факторного признака. Например, признак x - балл оценки плодородия почв, признак y - урожайность сельскохозяйственной культуры. Здесь совершенно ясно логически, какой признак является независимой переменной (фактор) x, какой - зависимой переменной (результат) y. -

Совершенно иная интерпретация нужна при изучении корреляционной связи между двумя следствиями одной причины. Известен классический пример, приведенный крупнейшим статистиком России начала XXв А.А. Чупровым: если в качестве признака x взять число пожарных команд в городе, а за признак y - сумму убытков за год в городе от пожаров, то между признаками x и y в совокупности городов России существенная прямая корреляция; в среднем, чем больше пожарников в городе, тем больше и убытков от пожаров. Уж не занимались ли поджигательством из боязни потерять работу? Но дело в другом. Данную корреляцию нельзя интерпретировать как связь причины и следствия; оба признака - следствия общей причины - размера города. Вполне логично, что в крупных городах больше пожарных частей, но и больше пожаров, и убытков от них за год, чем в мелких городах. -

Третий путь возникновения корреляции - взаимосвязь признаков, каждый из которых и причина и следствие. В биологии примером таких взаимосвязей являются механизмы биологических обратных связей между параметрами организма при поддержании гомеостаза.

Вычисление и интерпретация параметров

парной линейной корреляции

Простейшей системой корреляционной связи является линейная связь между двумя признаками - парная линейная корреляция. Практическое ее значение в том, что есть системы, в которых среди всех факторов

, влияющих на результативный признак, выделяется один важнейший фактор, который в основном определяет вариацию результативного признака. Измерение парных корреляций составляет необходимый этап в изучении сложных, многофакторных связей. Есть такие системы связей, при изучении которых необходимо предпочесть парную корреляцию.

Условия применения и ограничения корреляционно анализа

Поскольку корреляционная связь является статистической, первым условием возможности ее изучения является общее условие всякого статистической исследования: наличие данных по достаточно большой совокупности явлений. По отдельным явлениям можно получить совершенно неправильное представление о связи признаков, ибо в каждом отдельном явлении значения признаков кроме закономерной составляющей имеют случайное отклонение (вариацию).

Какое именно число наблюдений достаточно для анализа корреляционной и вообще статистической связи, зависит от цели анализа, требуемой точности и надежности параметров связи, от числа факторов с которыми корреляция изучается. Обычно считают, что число наблюдений должно быть не менее чем в 5-6 раз, а лучше не менее чем в 10 раз больше числа факторов. Еще лучше если число наблюдений в несколько десятков или в сотни раз больше числа факторов, тогда закон больших чисел, действуя в полную силу, обеспечивает эффективное взаимопогашение случайных отклонений от закономерного характера связи признаков.

Вторым условием закономерного проявления корреляционной связи служит условие, обеспечивающее надежное выражение закономерности в средней величине. Кроме уже указанного большого числа единиц совокупности для этого необходима достаточно качественная однородность совокупности. Нарушение этого условия может извратить параметры корреляции.

Наблюдается прямая зависимость между численностью животных и площадью на которой она подсчитывалась. Однако, есть колониальные животные и есть одиночные и, если исследовать зависимость между общим числом животных всех видов и площадью, то получится совершенно другая зависимость.

Иногда как условие корреляционного анализа выдвигают необходимость подчинения распределения совокупности по результативному и факторным признакам нормальному закону распределения вероятностей. Это условие связано с применением метода наименьших квадратов при расчете параметров корреляции: только при нормальном распределении метод наименьших квадратов дает оценку параметров, отвечающую принципам максимального правдоподобия. На практике эта предпосылка чаще всего выполняется приближенно, но и тогда метод наименьших квадратов дает неплохие результаты.

Однако при значительном отклонении распределений признаков от нормального закона нельзя оценивать надежность выборочного коэффициента корреляции, используя параметры нормального распределения вероятности или распределения Стьюдента.

Еще одним спорным вопросом является допустимость применения корреляционного анализа к функционально связанным признакам. Безусловно нельзя проводить корреляционный анализ в тех случаях когда заведомо известно, что между параметрами существует жестко детерминированная связь.

Однако, полезно проводить корреляционный анализ если уровень зависимости параметров обычно жестко детерминированных, может в ряде случаев принимать другую форму.

Корреляционный анализ учитывает межфакторные связи, следовательно дает нам более полное измерение роли каждого фактора: прямое, непосредственное его влияние на результативный признак; косвенное влияние фактора через влияние его на другие факторы; влияние всех факторов на результативный признак. Если связь между факторами несущественна, можно ограничиться индексным анализом. В противном случае его полезно дополнить корреляционно-регрессионным измерением влияния факторов, даже если они функционально связаны с результативным признаком.

Вычисление и интерпретация параметров

парной линейной корреляции

Простейшей системой корреляционной связи является линейная связь между двумя признаками - парная линейная корреляция. Практическое ее значение в том, что есть системы, в которых среди всех факторов, влияющих на результативный признак, выделяется один важнейший фактор, который в основном определяет вариацию результативного признака. Измерение парных корреляций составляет необходимый этап в изучении сложных, многофакторных связей. Есть такие системы связей, при изучении которых необходимо предпочесть парную корреляцию.

Измерение связи количественных признаков

В случае, когда параметры измеряются количественно, теснота парной линейной корреляционной связи может быть измерена корреляционным отношением:

.

.Кроме того, при линейной форме уравнения применяется и другой показатель тесноты связи - коэффициент корреляции r

xy. Этот показатель представляет собой стандартизованный коэф-фициент регрессии, т.е. коэффициент выраженный не в абсолют-ных единицах измерения признаков, а в долях среднего квадратичного отклонения результирующего признака:

.

.Коэффициент корреляции был предложен английским статистиком Пирсоном. Его интерпретация такова: отклонение признака-фактора от его среднего значения на величину своего среднего квадратичного отклонения в среднем по совокупности приводит к отклонению признака-результата от своего среднего значения на Rxy его среднего квадратичного отклонения.

Для интерпретации коэффициента корреляции необходимо знать область его существования 0<=|r|<=1. Как ясно из формулы, минимальное, именно нулевое значение коэффициента корреляции может быть достигнуто, если положительные и отрицательные произведения отклонений признаков от их средних величин в числителе уравновесят друг друга. Это свидетельствовало бы о полном отсутствии связи, но вероятность такого абсолютно точного взаимопогашения абсолютно мала для любой реальной, но бесконечно большой совокупности. Поэтому и при отсутствии реальной связи коэффициент корреляции на практике не равен 0. Максимально тесная связь - это связь функциональная.

Измерение связи порядковых признаков

Показатель ранговой корреляции Спирмена применяется в случаях, если изучается линейная связь между рядами, представленными в количественной или порядковой шкале. Практически при анализе количественных признаков применять показатель Спирмена вместо коэффициента корреляционного отношения Пирсона не следует, так как при его вычислении происходит понижение количественной шкалы до порядковой. Расчет ведется по формуле:

где ri,si, i=1,2, …, n – массивы рангов;

n – число пар вариант исследуемых рядов;

Bx,By – поправки на объединение рангов в соответствующих рядах;

m – число групп объединенных рангов в ряду;

ni, i=1,2, … , m – число рангов в i-й группе.

Предположим, что группа городов ранжирована по чис-ленности населения и уровню загрязненности окружающей среды.